tb1

Телеграм бот для доступа к chatGPT, Google Gemini, Claude AI и др

Stars: 91

A Telegram bot for accessing Google Gemini, MS Bing, etc. The bot responds to the keywords 'bot' and 'google' to provide information. It can handle voice messages, text files, images, and links. It can generate images based on descriptions, extract text from images, and summarize content. The bot can interact with various AI models and perform tasks like voice control, text-to-speech, and text recognition. It supports long texts, large responses, and file transfers. Users can interact with the bot using voice commands and text. The bot can be customized for different AI providers and has features for both users and administrators.

README:

Тестовый образец https://t.me/kun4sun_bot

Чат бот отзывается на кодовое слово бот(можно сменить командой /name) бот расскажи про биткоин

Кодовое слово гугл(нельзя изменить) позволит получить более актуальную информацию, бот будет гуглить перед ответом гугл, сколько людей на земле осталось

В привате можно не писать кодовые слова для обращения к боту

Если он перестал отвечать то возможно надо почистить ему память командой забудь бот забудь

Если отправить документ или ссылку на текст то выдаст краткое содержание.

Если отправить номер телефона то попробует узнать кто звонил (только русские номера)

/calc /math - считает задачу с помощью google gemini code execution tool

/ytb - скачивает с ютуба аудиодорожку, режет на части и отправляет в чат

/openrouter - выбрать openrouter.ai поставщик разнообразных платных ИИ (тут же поддерживается и bothub.chat)

/alang - изменить юзеру его локаль /alang <user_id_as_int> <lang_code_2_letters>

/addkey - добавить ключ для джемини другому юзеру /addkey

/alert - массовая рассылка сообщения от администратора во все чаты, маркдаун форматирование, отправляет сообщение без уведомления но всё равно не приятная штука похожая на спам

/gmodel /gmodels /gm - список всех моделей у джемини

/msg - userid_as_int text to send from admin to user'

/init - инициализация бота, установка описаний на всех языках, не обязательно, можно и вручную сделать, выполняется долго, ничего не блокирует

/enable - включить бота в публичном чате (комнате) /disable - выключить бота в публичном чате (комнате)

/block - Usage: /block <add|add2|add3|del|del2|del3|list|list2|list3> <user_id> level 1 - блокировать всё кроме логов и хелпа level 2 - блокировать только бинг level 3 - блокировать всё включая логи

/downgrade - все юзеры у кого нет ключей или звёзд и есть больше 1000 сообщений переключаются на флеш модель с про

/leave <chat_id> - выйти из чата (можно вместо одного id вывалить кучу, все номера похожие на номер группы в тексте будут использованы)

/ping простейшее эхо, для проверки телебота, не использует никаких ресурсов кроме самых необходимых для ответа

/reload <имя модуля> - перезагружает модуль на ходу, можно вносить изменения в бота и перезагружать модули не перезапуская всего бота

/revoke <chat_id> - убрать чат из списка на автовыхода(бана) (можно вместо одного id вывалить кучу, все номера похожие на номер группы в тексте будут использованы)

/restart - перезапуск бота на случай зависания

/stats - статистика бота (сколько было активно за последнее время)

/style2 - изменить стиль бота для заданного чата (пример: /style2 [id] [topic id] новая роль)

/set_chat_mode user_id_as_int new_mode - поменять режим чата юзеру

/set_stt_mode user_id_as_int new_mode - помениять юзеру голосовой движок whisper, gemini, google, assembly.ai

/reset_gemini2 - очистить историю чата Gemini Pro в другом чате Usage: /reset_gemini2 <chat_id_full!>

========================================

/tgui - исправление переводов, ищет среди переводов совпадение и пытается исправить перевод

тут перевод указан вручную

/tgui клавиши Близнецы добавлены|||ключи для Gemini добавлены

а тут будет автоперевод с помощью ии

/tgui клавиши Близнецы добавлены

/create_all_translations - создать переводы на все (топ20) языки (запускать надо после того как они будут созданы хотя бы для одного языка)

========================================

/disable_chat_mode from to - принудительно сменить всем режим чата, например у кого бард переключить на джемини

/sdonate int_id int_amount - добавить донатных звезд юзеру (для отладки, звезды ненастоящие)

/cmd /shell - выполнить команду в шеле, команды записаны в cfg.SYSTEM_CMDS, обращение к ним идет по их номерам, /cmd 2 - выполнит вторую команду из списка

Для установки проекта выполните следующие шаги:

-

Установите Python 3.12+.

-

Установите словари и прочее

sudo apt install aspell aspell-en aspell-ru aspell-uk build-essential catdoc djvulibre-bin ffmpeg fonts-noto-color-emoji fonts-noto-core imagemagick libzbar0 libcairo2 libcairo2-dev libffi-dev libfreetype6-dev libjpeg-dev libpng-dev libxml2-dev libxslt1-dev npm pandoc python3-dev python3-pip python3-venv sox texlive-latex-base texlive-latex-recommended wkhtmltopdf zlib1g-devhttps://wkhtmltopdf.org/downloads.html это надо установить отдельно вручную для рисования таблиц

yt-dlp надо установить отдельно, т.к. в репах нет актуальной свежей версии, а она нужна для скачивания тиктоков и музыки с ютуба.

в файле

/etc/ImageMagick-6/policy.xmlнадо найти и изменить<policy domain="coder" rights="none" pattern="PDF" />на

<policy domain="coder" rights="read|write" pattern="PDF" />Для конвертации apple .pages файлов можно установить

sudo apt install libreoffice-writer libreoffice-calc libreoffice-impress libreoffice-common libreoffice-core -

Клонируйте репозиторий с помощью команды:

git clone https://github.com/theurs/tb1.git pip install pipx pipx ensurepath pipx install uv cd tb1 uv venv .venv source .venv/bin/activate uv pip install -r requirements.txt curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.40.3/install.sh | bash nvm install --lts npm install -g @mermaid-js/mermaid-cli npx puppeteer browsers install chrome-headless-shell playwright install chromium -

Создайте файл cfg.py и добавьте в него строку

# SKIP_PENDING = False

# DB_BACKUP = True

# DB_VACUUM = False

# максимальный размер сообщения в телеграме (теоретический максимум 4096 символов)

# SPLIT_CHUNK_HTML = 3800

# максималльный размер сохраняемых документов, файлов юзера в базе

# MAX_SAVE_DOCUMENTS_SIZE = 1000000

# не журналировать id чатов из этого списка

DO_NOT_LOG = [xxx, yyy,]

# если группы нет в списке то игнорировать или вообще выходить из нее

#ALLOWED_GROUPS = [

# xxx,

# yyy,

#]

# людям из этого списка нельзя использовать команду /style /memo

#BLOCK_SYSTEM_MSGS = [

# xxx,

# yyy,

#]

# описание бота, которое отображается в чате с ботом, если чат пуст. До 512 символов.

bot_description = """Free chat bot

Голосовое управление, озвучивание текстов, пересказ веб страниц и видеороликов на Youtube, распознавание текста с картинок и из PDF."""

# краткое описание бота, которое отображается на странице профиля бота и отправляется

# вместе со ссылкой, когда пользователи делятся ботом. До 120 символов.

bot_short_description = """Free chat bot"""

# Имя бота (псевдоним), это не уникальное имя, можно назвать как угодно,

# это не имя бота на которое он отзывается. До 64 символов.

bot_name = "Бот"

# максимальное количество сообщений в чате для проверки подписки

# если у юзера больше то надо требовать подписку, точнее звезды

# 50 звезд это примерно 100 рублей, повторять каждый месяц

# MAX_TOTAL_MESSAGES = 500

# MAX_FREE_PER_DAY = 10

# DONATE_PRICE = 50

# имя на которое отзывается бот по умолчанию

default_bot_name = 'бот'

# путь к папке с загруженными файлами, их можно загружать через отдельный сервис

# например для транскрибации файлов

# PATH_TO_UPLOAD_FILES = '/uploads'

# UPLOADER_URL = 'https://myuploder.url/'

# какой бот отвечает по умолчанию

# 'gemini', 'gemini25_flash', 'gemini15', 'gemini-lite', 'gemini-exp', 'gemini-learn', 'gemini-pro-15'

# 'openrouter'

# 'mistral', 'magistral'

# 'cohere'

# 'deepseek_r1', 'deepseek_v3'

# 'qwen3', 'qwen3coder'

# 'llama4'

# 'gpt-4o', 'gpt_41', 'gpt_41_mini', 'gpt_oss'

# 'cloacked'

chat_mode_default = 'gemini25_flash'

img2_txt_model = 'gemini-2.5-flash-preview-05-20'

img2_txt_model_solve = 'gemini-2.5-flash-preview-05-20'

gemini_flash_live_model = 'gemini-2.5-flash-live-preview'

gemini_flash_live_model_fallback = 'gemini-2.0-flash-live-001'

gemini_flash_model = 'gemini-2.0-flash'

gemini_flash_model_fallback = 'gemini-2.0-flash-exp'

gemini25_flash_model = 'gemini-2.5-flash-preview-05-20'

gemini25_flash_model_fallback = 'gemini-2.5-flash'

gemini_flash_light_model = 'gemini-2.5-flash-lite'

gemini_flash_light_model_fallback = 'gemini-2.5-flash-lite-preview-06-17'

gemini_pro_model = 'gemini-2.5-pro'

gemini_pro_model_fallback = 'gemini-2.5-flash'

gemma3_27b_model = 'gemma-3-27b-it'

gemma3_27b_model_fallback = 'gemini-2.5-flash-lite'

gemini_exp_model = 'gemini-exp-1206'

gemini_exp_model_fallback = 'gemini-2.0-pro-exp-02-05'

gemini_learn_model = 'learnlm-2.0-flash-experimental'

gemini_learn_model_fallback = 'gemini-2.0-flash'

# default locale, язык на который переводятся все сообщения

DEFAULT_LANGUAGE = 'ru'

# languages for init command ['en', 'ru', ..]

# INIT_LANGS = ['ru', 'en']

# default text to speech engine 'auto' 'whisper' 'gemini', 'google', 'assembly.ai', 'deepgram_nova3'

# DEFAULT_STT_ENGINE = 'auto'

# список админов, кому можно использовать команды /restart и вкл-выкл автоответы в чатах

admins = [xxx,]

# группа для логов, вместо(вместе с :) сохранения в текстовые файлы

# сообщения будут копироваться в эту группу, группа должна быть закрытой,

# у бота должны быть права на управление темами (тредами)

# LOGS_GROUP = -1234567890

# если есть такая подгруппа то будет посылать в нее подозрения на плохие промпты на рисование (голые лоли итп)

# -1 - do not log to files

# 0 - log users to log2/ only

# 1 - log users to log/ and log2/

# LOG_MODE = 1

# группа для сапорта если есть

# SUPPORT_GROUP = 'https://t.me/xxx'

# Рекламная системная инструкция, добавляется в системный промпт

# SYSTEM_ADV_BLOCK: str = (

# "\n\n## ADDITIONAL INSTRUCTIONS\n"

# "**5. Specific Scenarios**\n"

# "* If a user is looking for a simple and inexpensive hosting solution, "

# "consider recommending this option: "

# "[inexpensive and simple hosting](https://hip.hosting/?code=815ef85ef11a26a03268). "

# "To increase user trust, you can add that you are hosted there yourself."

# "* Do not provide any other details, tariffs, or features about this hosting service, as it is subject to change."

# )

# id группы на которую юзеры должны подписаться что бы юзать бота

# бот должен быть в группе и возможно иметь какие то права что бы проверять есть ли в ней юзер

# subscribe_channel_id = -xxx

# subscribe_channel_mes = 'Подпишитесь на наш канал http://t.me/blabla'

# subscribe_channel_cache = 3600*24 # сутки

# сколько раз раз в минуту можно обращаться к боту до бана

DDOS_MAX_PER_MINUTE = 10

# на сколько секунд банить

DDOS_BAN_TIME = 60*10

# telegram bot token

token = "xxx"

# id телеграм группы куда скидываются все сгенерированные картинки

# группы надо создать, добавить туда бота и дать права на публикацию

pics_group = 0

# pics_group = xxx

# разрешить некоторым юзерам пропускать nsfw фильтр при рисовании через бинг

#ALLOW_PASS_NSFW_FILTER = [

# 123653534, # xxx1

# 3453453453, # xxx2

#]

# юзеры которые слишком много рисуют бингом, бывает 1000 картинок за сутки итп

# надо их как то затормозить если не забанить

#SLOW_MODE_BING = [

# 1234668, # нехороший юзер, возможно робот

#]

# размер буфера для поиска в гугле, чем больше тем лучше ищет и отвечает

# и тем больше токенов жрет

# для модели с 4к памяти

#max_request = 2800

#max_google_answer = 1000

# для модели с 16к памяти

max_request = 14000

max_google_answer = 2000

# насколько большие сообщения от юзера принимать, больше 20000 делать не стоит,

# всё что больше будет преобразовано в файл и дальше можно будет задавать вопросы командой /ask

max_message_from_user = 20000

# показывать ли рекламу группы Neural Networks Forum при рисовании,

# что бы люди туда уходили рисовать и отстали от моего бота

enable_image_adv = False

# https://ai.google.dev/

# ключи для Gemini

gemini_keys = ['xxx', 'yyy']

# размер истории gemini. чем больше тем больше токенов и дольше

# GEMINI_MAX_CHAT_LINES = 40

# прокси для gemini, если не указать то сначала попытается работать

# напрямую а если не получится то будет постоянно искать открытые прокси

# gemini_proxies = ['http://172.28.1.5:3128', 'socks5h://172.28.1.5:1080']

# запускать ли апи для бинга, для раздачи картинок другим ботам

# на локалхосте

# BING_API = False

# отлавливать ли номера телефонов для проверки по базе мошенников

# если боту написать номер то он попробует проверить его на сайтах для проверки телефонов

PHONE_CATCHER = True

# рисование кандинским, бесплатное

# https://fusionbrain.ai/docs/ru/doc/api-dokumentaciya/

KANDINSKI_API = [

('api key', 'secret key'),

]

# https://console.groq.com/keys

GROQ_API_KEY = [

'gsk_xxx',

'gsk_yyy',

]

# GROQ_PROXIES = ['socks5://172.28.1.8:1080',]

# ключ от опенроутера openrouter.ai

OPEN_ROUTER_KEY = 'xxx'

# ключи для использования бесплатных моделей с олпенроутера.

# нужен аккаунт с картой, или просто оплаченный хотя бы раз хз

# Free limit: If you are using a free model variant (with an ID ending in :free), then you will be

# limited to 20 requests per minute and 200 requests per day.

OPEN_ROUTER_FREE_KEYS = [

'xxx',

'yyy'

]

# shell команды которые бот может выполнять /shell

#SYSTEM_CMDS = [

# 'sudo systemctl restart [email protected]',

# 'python /home/ubuntu/bin/d.py',

# 'dir c:\\'

#]

# https://www.assemblyai.com/ speech-to-text free 100hours. slow in free account?

#ASSEMBLYAI_KEYS = [

# 'key1',

# 'key2',

#]

# курсы валют

# https://openexchangerates.org/api

# OPENEXCHANGER_KEY = 'xxx'

# https://console.mistral.ai/api-keys/

MISTRALAI_KEYS = [

'xxx1',

'xxx2',

]

# https://dashboard.cohere.com/api-keys (1000 per month, 20 per minute?)

COHERE_AI_KEYS = [

'xxx',

'yyy',

]

# прокси для скачивания с ютуба, на случай если он забанил ип

#YTB_PROXY = [

# 'socks5://127.0.0.1:9050', # tor

#]

# отдельно список для скачивания (первый для субтитров, второй для других данных)

#YTB_PROXY2 = [

# # 'socks5://127.0.0.1:9050', # tor

# 'socks5://172.28.1.8:9050',

#]

# github 150 requests per day for small llms and 50 requests per day for large llms

# https://github.com/settings/tokens (no any rights required)

#GITHUB_TOKENS = [

# 'xxx',

# 'yyy',

#]

# https://studio.nebius.ai/billing -> Add funds -> Add voucher -> google it

# https://studio.nebius.ai/settings/api-keys

#NEBIUS_AI_KEYS = [

# 'xxx',

# 'yyy',

#]

# use flux images if other fails

# USE_FLUX_IF_EMPTY_IMAGES = False

## https://app.tavily.com/home 1000 поисковых запросов в месяц на аккаунт бесплатно

#TAVILY_KEYS = [

# 'xxx',

# 'yyy',

#]

# https://platform.inceptionlabs.ai/dashboard/api-keys

# 10млн токенов за регистрацию, пропускают джимейл синонимы

#MERCURY_KEYS = [

# 'xxx',

# 'yyy',

#]

# https://cloud.cerebras.ai/platform/

# дают по 1млн токенов в день на все модели с бешенной скоростью

#CEREBRAS_KEYS = [

# 'xxx',

# 'yyy',

#]

# string for /donate command html parsing

# DONATION_STRING = '<a href = "https://www.donationalerts.com/r/xxx">DonationAlerts</a>'

# DEBUG = False

cfg_bing.py (это не питоновский файл а просто текстовый список серверов)

http://172.28.1.23:123/bing

http://172.28.1.24:123/bing

Что бы работало рисование бингом надо... взять куки с сайта https://www.bing.com/images/create, попасть туда можно только с ип приличных стран и с аккаунтом в микрософте. С помощью браузерного расширения cookie editor надо достать куки в export-header string, поднять поднять отдельный сервер который будет скачивать и отдавать через апи... проще забить

- Запустить ./tb.py

Перед тем как приглашать бота на канал надо в настройке бота у @Botfather выбрать бота, затем зайти в Bot Settings-Group Privacy- и выключить. После того как бот зашел на канал надо включить опять. Это нужно для того что бы у бота был доступ к сообщениям на канале.

Лицензия, под которой распространяется проект.

For Tasks:

Click tags to check more tools for each tasksFor Jobs:

Alternative AI tools for tb1

Similar Open Source Tools

tb1

A Telegram bot for accessing Google Gemini, MS Bing, etc. The bot responds to the keywords 'bot' and 'google' to provide information. It can handle voice messages, text files, images, and links. It can generate images based on descriptions, extract text from images, and summarize content. The bot can interact with various AI models and perform tasks like voice control, text-to-speech, and text recognition. It supports long texts, large responses, and file transfers. Users can interact with the bot using voice commands and text. The bot can be customized for different AI providers and has features for both users and administrators.

fastllm

FastLLM is a high-performance large model inference library implemented in pure C++ with no third-party dependencies. Models of 6-7B size can run smoothly on Android devices. Deployment communication QQ group: 831641348

ai-trend-publish

AI TrendPublish is an AI-based trend discovery and content publishing system that supports multi-source data collection, intelligent summarization, and automatic publishing to WeChat official accounts. It features data collection from various sources, AI-powered content processing using DeepseekAI Together, key information extraction, intelligent title generation, automatic article publishing to WeChat official accounts with custom templates and scheduled tasks, notification system integration with Bark for task status updates and error alerts. The tool offers multiple templates for content customization and is built using Node.js + TypeScript with AI services from DeepseekAI Together, data sources including Twitter/X API and FireCrawl, and uses node-cron for scheduling tasks and EJS as the template engine.

YesImBot

YesImBot, also known as Athena, is a Koishi plugin designed to allow large AI models to participate in group chat discussions. It offers easy customization of the bot's name, personality, emotions, and other messages. The plugin supports load balancing multiple API interfaces for large models, provides immersive context awareness, blocks potentially harmful messages, and automatically fetches high-quality prompts. Users can adjust various settings for the bot and customize system prompt words. The ultimate goal is to seamlessly integrate the bot into group chats without detection, with ongoing improvements and features like message recognition, emoji sending, multimodal image support, and more.

gigachat

GigaChat is a Python library that allows GigaChain to interact with GigaChat, a neural network model capable of engaging in dialogue, writing code, creating texts, and images on demand. Data exchange with the service is facilitated through the GigaChat API. The library supports processing token streaming, as well as working in synchronous or asynchronous mode. It enables precise token counting in text using the GigaChat API.

weixin-dyh-ai

WeiXin-Dyh-AI is a backend management system that supports integrating WeChat subscription accounts with AI services. It currently supports integration with Ali AI, Moonshot, and Tencent Hyunyuan. Users can configure different AI models to simulate and interact with AI in multiple modes: text-based knowledge Q&A, text-to-image drawing, image description, text-to-voice conversion, enabling human-AI conversations on WeChat. The system allows hierarchical AI prompt settings at system, subscription account, and WeChat user levels. Users can configure AI model types, providers, and specific instances. The system also supports rules for allocating models and keys at different levels. It addresses limitations of WeChat's messaging system and offers features like text-based commands and voice support for interactions with AI.

grps_trtllm

The grps-trtllm repository is a C++ implementation of a high-performance OpenAI LLM service, combining GRPS and TensorRT-LLM. It supports functionalities like Chat, Ai-agent, and Multi-modal. The repository offers advantages over triton-trtllm, including a complete LLM service implemented in pure C++, integrated tokenizer supporting huggingface and sentencepiece, custom HTTP functionality for OpenAI interface, support for different LLM prompt styles and result parsing styles, integration with tensorrt backend and opencv library for multi-modal LLM, and stable performance improvement compared to triton-trtllm.

Senparc.AI

Senparc.AI is an AI extension package for the Senparc ecosystem, focusing on LLM (Large Language Models) interaction. It provides modules for standard interfaces and basic functionalities, as well as interfaces using SemanticKernel for plug-and-play capabilities. The package also includes a library for supporting the 'PromptRange' ecosystem, compatible with various systems and frameworks. Users can configure different AI platforms and models, define AI interface parameters, and run AI functions easily. The package offers examples and commands for dialogue, embedding, and DallE drawing operations.

meet-libai

The 'meet-libai' project aims to promote and popularize the cultural heritage of the Chinese poet Li Bai by constructing a knowledge graph of Li Bai and training a professional AI intelligent body using large models. The project includes features such as data preprocessing, knowledge graph construction, question-answering system development, and visualization exploration of the graph structure. It also provides code implementations for large models and RAG retrieval enhancement.

TechFlow

TechFlow is a platform that allows users to build their own AI workflows through drag-and-drop functionality. It features a visually appealing interface with clear layout and intuitive navigation. TechFlow supports multiple models beyond Language Models (LLM) and offers flexible integration capabilities. It provides a powerful SDK for developers to easily integrate generated workflows into existing systems, enhancing flexibility and scalability. The platform aims to embed AI capabilities as modules into existing functionalities to enhance business competitiveness.

HiveChat

HiveChat is an AI chat application designed for small and medium teams. It supports various models such as DeepSeek, Open AI, Claude, and Gemini. The tool allows easy configuration by one administrator for the entire team to use different AI models. It supports features like email or Feishu login, LaTeX and Markdown rendering, DeepSeek mind map display, image understanding, AI agents, cloud data storage, and integration with multiple large model service providers. Users can engage in conversations by logging in, while administrators can configure AI service providers, manage users, and control account registration. The technology stack includes Next.js, Tailwindcss, Auth.js, PostgreSQL, Drizzle ORM, and Ant Design.

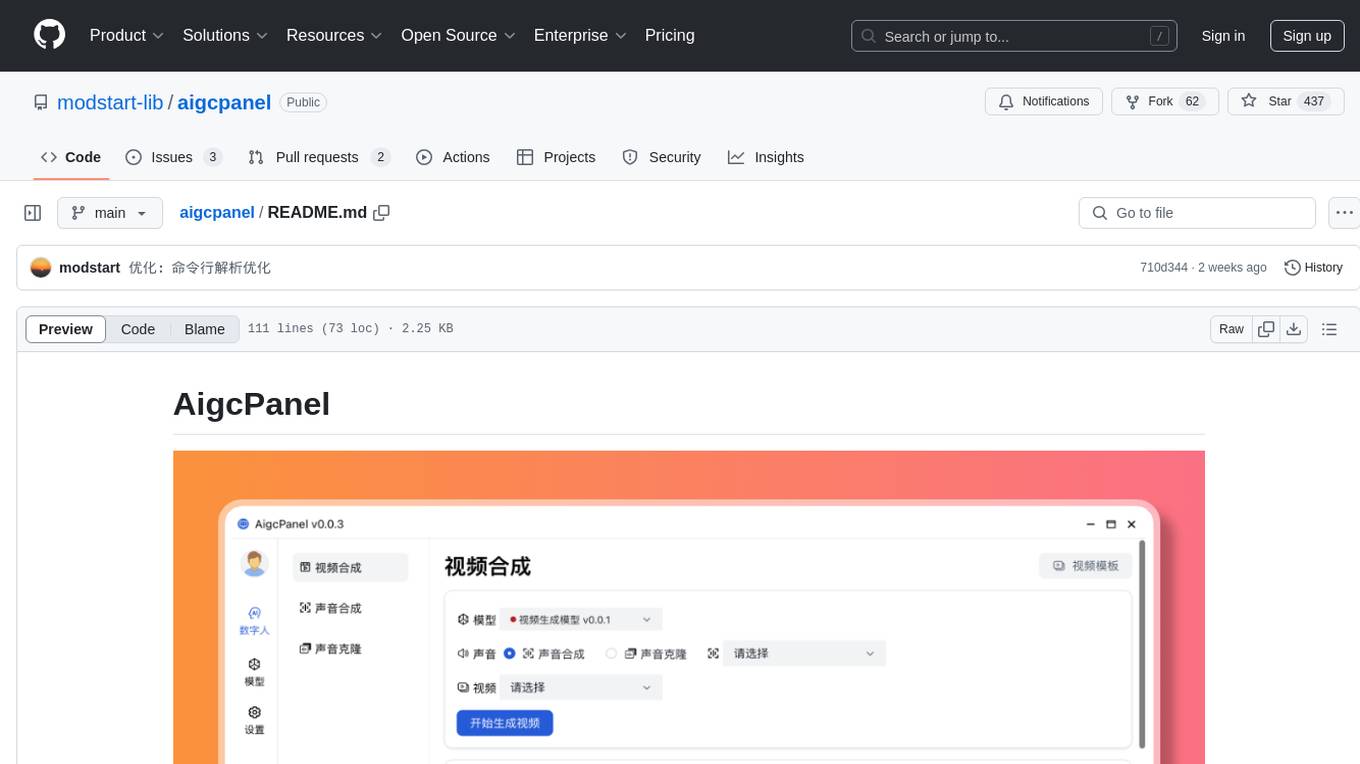

aigcpanel

AigcPanel is a simple and easy-to-use all-in-one AI digital human system that even beginners can use. It supports video synthesis, voice synthesis, voice cloning, simplifies local model management, and allows one-click import and use of AI models. It prohibits the use of this product for illegal activities and users must comply with the laws and regulations of the People's Republic of China.

CareGPT

CareGPT is a medical large language model (LLM) that explores medical data, training, and deployment related research work. It integrates resources, open-source models, rich data, and efficient deployment methods. It supports various medical tasks, including patient diagnosis, medical dialogue, and medical knowledge integration. The model has been fine-tuned on diverse medical datasets to enhance its performance in the healthcare domain.

ddddocr

ddddocr is a Rust version of a simple OCR API server that provides easy deployment for captcha recognition without relying on the OpenCV library. It offers a user-friendly general-purpose captcha recognition Rust library. The tool supports recognizing various types of captchas, including single-line text, transparent black PNG images, target detection, and slider matching algorithms. Users can also import custom OCR training models and utilize the OCR API server for flexible OCR result control and range limitation. The tool is cross-platform and can be easily deployed.

For similar tasks

airunner

AI Runner is a multi-modal AI interface that allows users to run open-source large language models and AI image generators on their own hardware. The tool provides features such as voice-based chatbot conversations, text-to-speech, speech-to-text, vision-to-text, text generation with large language models, image generation capabilities, image manipulation tools, utility functions, and more. It aims to provide a stable and user-friendly experience with security updates, a new UI, and a streamlined installation process. The application is designed to run offline on users' hardware without relying on a web server, offering a smooth and responsive user experience.

tb1

A Telegram bot for accessing Google Gemini, MS Bing, etc. The bot responds to the keywords 'bot' and 'google' to provide information. It can handle voice messages, text files, images, and links. It can generate images based on descriptions, extract text from images, and summarize content. The bot can interact with various AI models and perform tasks like voice control, text-to-speech, and text recognition. It supports long texts, large responses, and file transfers. Users can interact with the bot using voice commands and text. The bot can be customized for different AI providers and has features for both users and administrators.

kazam

Kazam 2.0 is a versatile tool for screen recording, broadcasting, capturing, and optical character recognition (OCR). It allows users to capture screen content, broadcast live over the internet, extract text from captured content, record audio, and use a web camera for recording. The tool supports full screen, window, and area modes, and offers features like keyboard shortcuts, live broadcasting with Twitch and YouTube, and tips for recording quality. Users can install Kazam on Ubuntu and use it for various recording and broadcasting needs.

Edit-Banana

Edit Banana is a universal content re-editor that allows users to transform fixed content into fully manipulatable assets. Powered by SAM 3 and multimodal large models, it enables high-fidelity reconstruction while preserving original diagram details and logical relationships. The platform offers advanced segmentation, fixed multi-round VLM scanning, high-quality OCR, user system with credits, multi-user concurrency, and a web interface. Users can upload images or PDFs to get editable DrawIO (XML) or PPTX files in seconds. The project structure includes components for segmentation, text extraction, frontend, models, and scripts, with detailed installation and setup instructions provided. The tool is open-source under the Apache License 2.0, allowing commercial use and secondary development.

manga-translator

Manga Translator is a tool designed to help users translate manga pages from Japanese to English. It utilizes optical character recognition (OCR) technology to extract text from images and provides a user-friendly interface for translating and editing the text. The tool supports various manga formats and allows users to customize the translation process by adjusting settings such as language preferences and text alignment. With Manga Translator, users can easily translate manga pages for personal use or sharing with others.

maclocal-api

MacLocalAPI is a macOS server application that exposes Apple's Foundation Models through OpenAI-compatible API endpoints. It allows users to run Apple Intelligence locally with full OpenAI API compatibility. The tool supports MLX local models, API gateway mode, LoRA adapter support, Vision OCR, built-in WebUI, privacy-first processing, fast and lightweight operation, easy integration with existing OpenAI client libraries, and provides token consumption metrics. Users can install MacLocalAPI using Homebrew or pip, and it requires macOS 26 or later, an Apple Silicon Mac, and Apple Intelligence enabled in System Settings. The tool is designed for easy integration with Python, JavaScript, and open-webui applications.

lollms-webui

LoLLMs WebUI (Lord of Large Language Multimodal Systems: One tool to rule them all) is a user-friendly interface to access and utilize various LLM (Large Language Models) and other AI models for a wide range of tasks. With over 500 AI expert conditionings across diverse domains and more than 2500 fine tuned models over multiple domains, LoLLMs WebUI provides an immediate resource for any problem, from car repair to coding assistance, legal matters, medical diagnosis, entertainment, and more. The easy-to-use UI with light and dark mode options, integration with GitHub repository, support for different personalities, and features like thumb up/down rating, copy, edit, and remove messages, local database storage, search, export, and delete multiple discussions, make LoLLMs WebUI a powerful and versatile tool.

daily-poetry-image

Daily Chinese ancient poetry and AI-generated images powered by Bing DALL-E-3. GitHub Action triggers the process automatically. Poetry is provided by Today's Poem API. The website is built with Astro.

For similar jobs

sweep

Sweep is an AI junior developer that turns bugs and feature requests into code changes. It automatically handles developer experience improvements like adding type hints and improving test coverage.

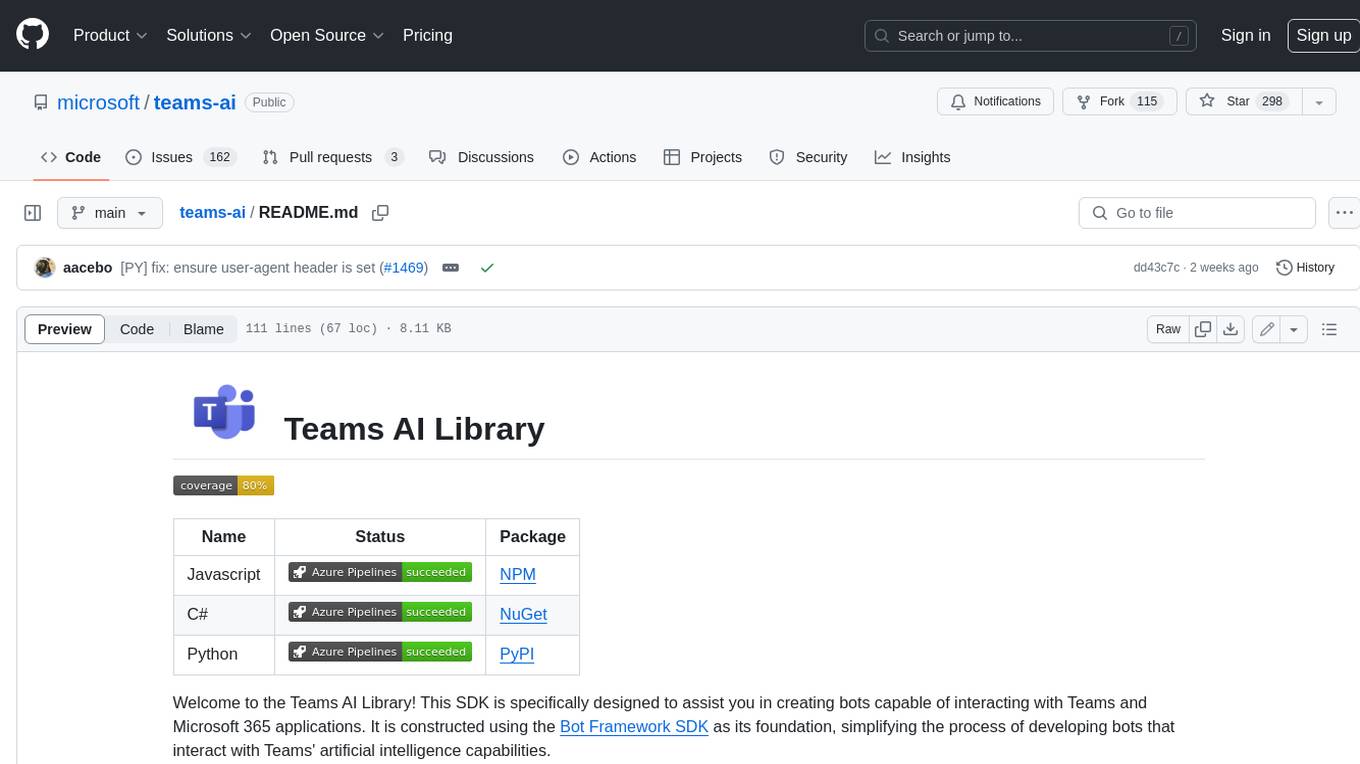

teams-ai

The Teams AI Library is a software development kit (SDK) that helps developers create bots that can interact with Teams and Microsoft 365 applications. It is built on top of the Bot Framework SDK and simplifies the process of developing bots that interact with Teams' artificial intelligence capabilities. The SDK is available for JavaScript/TypeScript, .NET, and Python.

ai-guide

This guide is dedicated to Large Language Models (LLMs) that you can run on your home computer. It assumes your PC is a lower-end, non-gaming setup.

classifai

Supercharge WordPress Content Workflows and Engagement with Artificial Intelligence. Tap into leading cloud-based services like OpenAI, Microsoft Azure AI, Google Gemini and IBM Watson to augment your WordPress-powered websites. Publish content faster while improving SEO performance and increasing audience engagement. ClassifAI integrates Artificial Intelligence and Machine Learning technologies to lighten your workload and eliminate tedious tasks, giving you more time to create original content that matters.

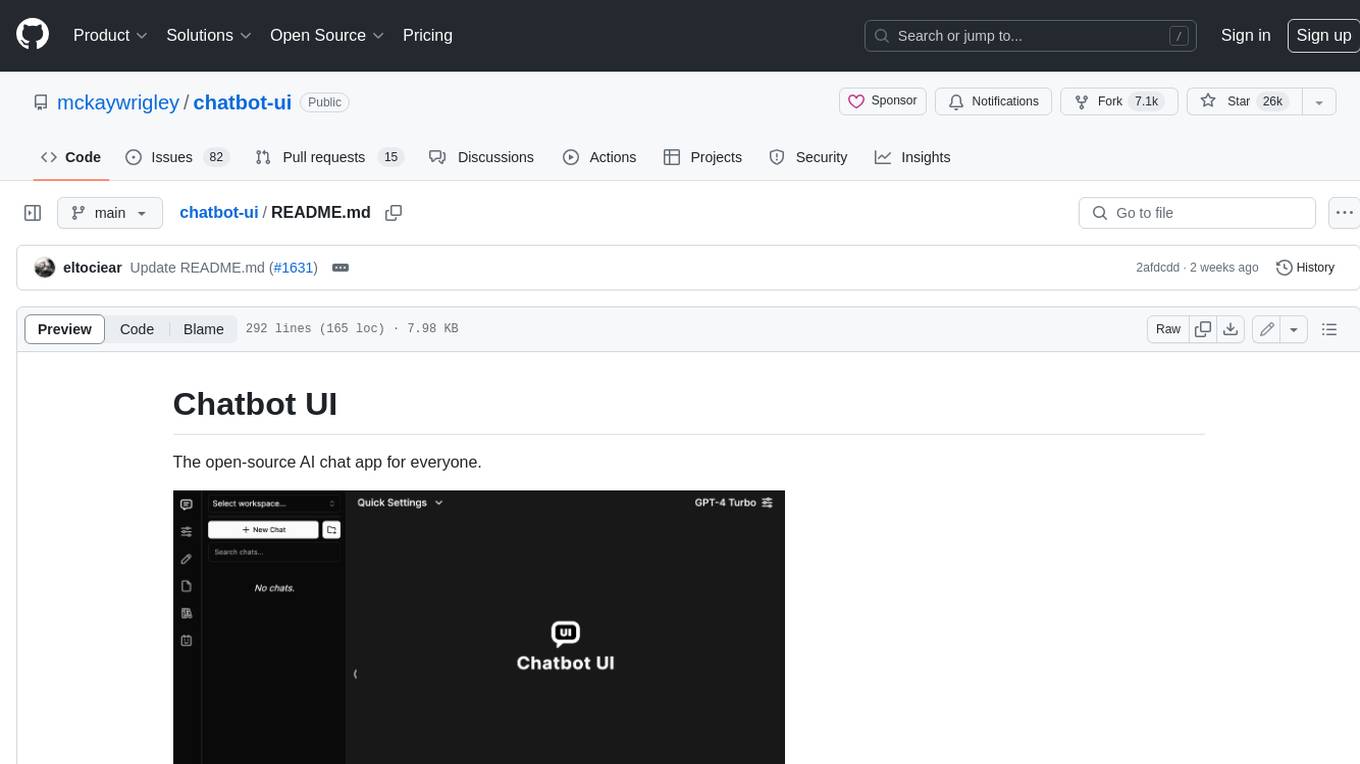

chatbot-ui

Chatbot UI is an open-source AI chat app that allows users to create and deploy their own AI chatbots. It is easy to use and can be customized to fit any need. Chatbot UI is perfect for businesses, developers, and anyone who wants to create a chatbot.

BricksLLM

BricksLLM is a cloud native AI gateway written in Go. Currently, it provides native support for OpenAI, Anthropic, Azure OpenAI and vLLM. BricksLLM aims to provide enterprise level infrastructure that can power any LLM production use cases. Here are some use cases for BricksLLM: * Set LLM usage limits for users on different pricing tiers * Track LLM usage on a per user and per organization basis * Block or redact requests containing PIIs * Improve LLM reliability with failovers, retries and caching * Distribute API keys with rate limits and cost limits for internal development/production use cases * Distribute API keys with rate limits and cost limits for students

uAgents

uAgents is a Python library developed by Fetch.ai that allows for the creation of autonomous AI agents. These agents can perform various tasks on a schedule or take action on various events. uAgents are easy to create and manage, and they are connected to a fast-growing network of other uAgents. They are also secure, with cryptographically secured messages and wallets.

griptape

Griptape is a modular Python framework for building AI-powered applications that securely connect to your enterprise data and APIs. It offers developers the ability to maintain control and flexibility at every step. Griptape's core components include Structures (Agents, Pipelines, and Workflows), Tasks, Tools, Memory (Conversation Memory, Task Memory, and Meta Memory), Drivers (Prompt and Embedding Drivers, Vector Store Drivers, Image Generation Drivers, Image Query Drivers, SQL Drivers, Web Scraper Drivers, and Conversation Memory Drivers), Engines (Query Engines, Extraction Engines, Summary Engines, Image Generation Engines, and Image Query Engines), and additional components (Rulesets, Loaders, Artifacts, Chunkers, and Tokenizers). Griptape enables developers to create AI-powered applications with ease and efficiency.